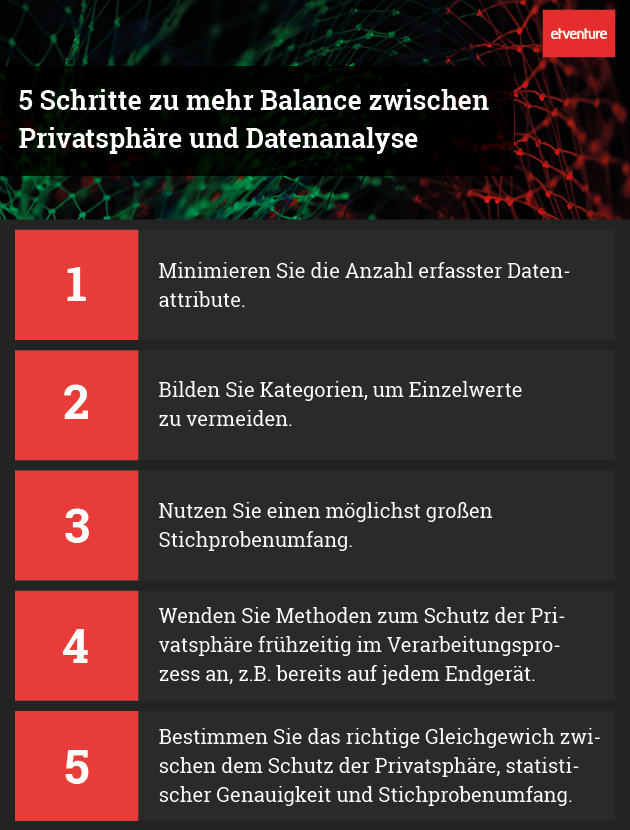

Differential Privacy: Mehr Balance zwischen Privatsphäre und Datenanalyse

14. Mai 2018

Der jüngste Skandal rund um Cambridge Analytica hat den Internet-Riesen Facebook in die größte Krise seiner Geschichte gestürzt. Und dennoch ist dies nur ein prominentes Beispiel für die missbräuchliche Nutzung sensibler Daten. Kein Wunder, dass die Menschen mehr und mehr besorgt sind, wie und von wem ihre persönlichen Daten verwendet werden.

“Der Verlust von Privatsphäre ist die ‚globale Erwärmung‘ des Informationszeitalters“

Wenn Daten das Öl des Informationszeitalters sind, dann könnte der Verlust der Privatsphäre die „globale Erwärmung“ sein. Während die einen leugnen, dass es einen Verlust an Privatsphäre gibt, sehen die anderen keinen Zusammenhang zwischen den jüngsten Skandalen. Wieder andere haben ernsthafte Furcht vor den Folgen. Wenn nichts unternommen wird, droht Facebook und der Datenanalyse-Community eine Gegenreaktion in Form verschärfter Regulierungen und Vorschriften. Diese könnten ihr Geschäftsmodell und ihre Zukunft ernsthaft bedrohen – ähnlich wie Automobilhersteller durch Emissionsnormen oder die Tabakindustrie durch Werbebeschränkungen reguliert werden.

Aber es gibt bereits Lösungsansätze, die dabei helfen können, die Potenziale der Datenanalysen auszuschöpfen und gleichzeitig die Privatsphäre zu bewahren. Eine Möglichkeit, mit individuellen Informationen verantwortungsvoll umzugehen, ist Differential Privacy. Einfach ausgedrückt wird dabei einem Datensatz absichtlich „Rauschen“ hinzugefügt, so dass die Privatsphäre des Einzelnen gewahrt bleibt. Die Gesamtanalyse bleibt aber weiterhin aussagekräftig und liefert qualitativ hochwertige Ergebnisse.

Wie Differential Privacy funktioniert

Wer glaubt, dass sich Datensätze anonymisieren lassen, indem Namen einfach durch IDs oder andere Platzhalter ersetzt werden, irrt gewaltig. Insbesondere bei Daten mit vielen Attributen oder vielen nur einmal vorkommenden Werten sind Personen leicht zu identifizieren. Das müsste spätestens seit dem Jahr 2006 bekannt sein, als AOL „anonymisierte“ Daten seiner Suchmaschine veröffentlichte. Dennoch ist der Irrglaube auch bis heute noch weit verbreitet.

Ein gängiges Beispiel zur Veranschaulichung von Differential Privacy basiert auf der “Randomisierung” von Antworten – einer in den 1960er Jahren entwickelten Technik. Dabei erhalten die Befragten die Möglichkeit, ihre individuelle Antwort zu einem späteren Zeitpunkt glaubwürdig abzustreiten. Ziel ist es, in Interviews ehrliche Antworten auf sensible, private Fragen zu sammeln. So wirft beispielsweise der Befragte eine Münze, bevor er die Frage beantwortet. Zeigt sie „Kopf“, soll er die Frage unabhängig von der Wahrheit mit „Ja“ beantworten. Bei „Zahl“ soll der Befragte wahrheitsgemäß antworten. Daher kann der Interviewer erwarten, dass eine Hälfte der „Ja“-Antworten durch den Münzwurf erzwungen ist und die andere Hälfte wahrheitsgetreue Antworten sind. Folglich ist der Prozentsatz der beobachteten „Nein“-Antworten nur halb so hoch wie der tatsächliche Prozentsatz. Da der Münzwurf vom Befragten im Geheimen durchgeführt wird, kann seine individuelle „Ja“-Antwort durch den Münzwurf erzwungen worden sein. Hierdurch wird die Privatsphäre der Umfrageteilnehmer garantiert, da sie später leugnen können, der Wahrheit entsprechend geantwortet zu haben.

Eine gängige Methode, einem nicht-kategorialen Datensatz “Rauschen” hinzuzufügen, ist die Verwendung einer symmetrischen Verteilung, wie z.B. Laplace oder Normalverteilung. Durch das “Rauschen” erhält der Datenanalytiker eine Art “Privatsphären-Budget”, um analytische Aufgaben mit einem bestimmten Datensatz durchzuführen. Mit Hilfe von Messung und Kontrolle dieses Budgets kann die individuelle Privatsphäre gewahrt werden. Gleichzeitig wird die Aussagekraft des Gesamtdatensatzes nicht beeinträchtigt.

Differential Privacy in der Praxis

Differential Privacy wird heute bereits in vielen Analyseprojekten eingesetzt. Insbesondere Apple fördert die intensive Nutzung in seinen Produkten. Was Benutzer auf ihren iPhone-Tastaturen eingeben oder welche Websites sie besuchen, sind hochgradig kritische Informationen. Apple hat eine Infrastruktur geschaffen, um spezifische analytische Anwendungsfälle zu beantworten, ohne die Privatsphäre der Nutzer zu gefährden. Ob es darum geht, welche Websites die meiste Energie verbrauchen oder welche Emojis die beliebtesten sind – noch bevor die Daten das Endgerät verlassen, werden Differential Privacy-Methoden angewendet. Identifikatoren und Zeitstempel werden entfernt, die Reihenfolge der gesammelten Ereignisse vermischt und zufälliges “Rauschen” hinzugefügt. In Apples Cloud werden die Informationen zahlreicher Endgeräte gesammelt und eine weitere Schicht von Differential Privacy-Tasks angewendet.

Datenanalysen am Scheideweg

Datenschutz und Privatsphäre sind eine dringende Angelegenheit – schließlich werden die Themen derzeit heiß diskutiert. Wie mit Informationen von Einzelpersonen umgegangen wird, entscheidet darüber, ob die derzeit weitreichende Freizügigkeit in der Datenanalyse Bestand haben wird. Für die Geschäftsmodelle führender Internet- und Technologiekonzerne kann dies fatale Konsequenzen haben.

Sollte die Datenanalyse-Community ihr “Privatsphären-Budget” voll ausschöpfen, wird die Öffentlichkeit bald mehr Risiken als Chancen in der Technologie sehen. Bewährte Methoden wie Differential Privacy können dabei helfen, den Schutz der Privatsphäre und das Bedürfnis nach statistischer Genauigkeit wieder in ein gesundes Gleichgewicht bringen. Deshalb liegt auf der Hand, dass Differential Privacy in naher Zukunft zum gängigen Handwerkszeug eines jeden Datenanalytikers gehören wird.

* Pflichtfeld